Кризис доверия к машинному обучению

Это зонтик или слон? Если бы человеку показали фотографию того или иного, на этот вопрос было бы невероятно просто ответить правильно. Для классификатора изображений с машинным обучением это может быть намного сложнее. Это связано с тем, что эти классификаторы могут сосредоточиться на элементах фона, границы изображения или других несущественных деталях - деталях, которые человек по своей природе считает несущественными - и считают их первостепенными при идентификации интересующего объекта на этом изображении. Что еще хуже, когда модели делают плохие прогнозы, они могут делать это с очень высокой степенью уверенности в том, что они действительно верны.

Хотя в настоящее время у нас может не быть лучших решений проблемы классификации, позволяющих машинам игнорировать неважные детали, как это сделал бы человек, теперь у нас есть метод, который, по крайней мере, поможет нам распознать, когда они сбиваются с пути в блаженном неведении. Исследователи из MIT CSAIL и Amazon Web Services совместно создали набор инструментов, который может определять модели, подверженные этому типу ошибки классификации, которую они называют чрезмерной интерпретацией.

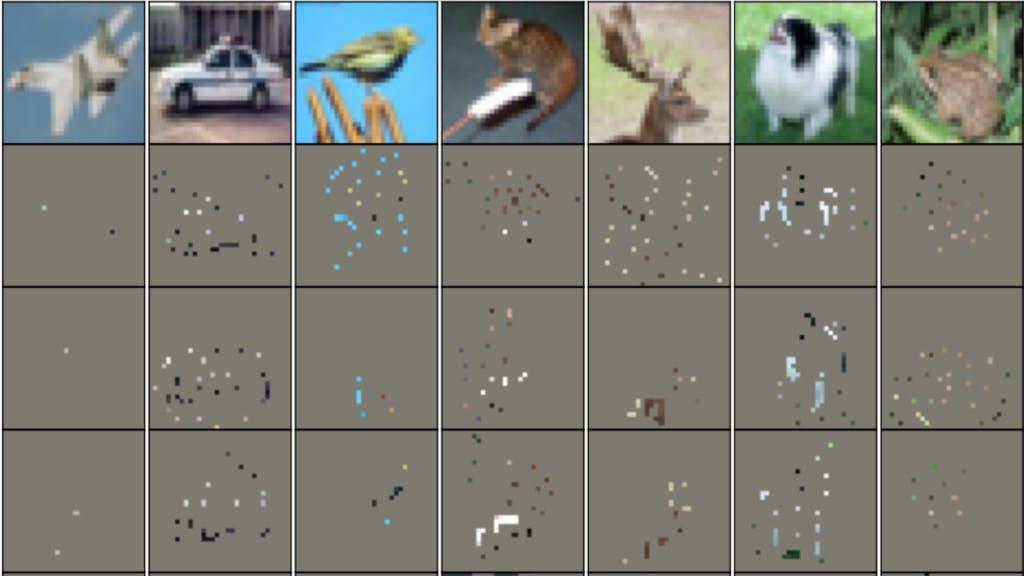

На высоком уровне этот инструмент будет методично удалять части изображения, а затем классифицировать их. Он продолжит этот процесс, чтобы найти наименьшее подмножество изображений, которое все еще классифицируется с высокой степенью достоверности. Когда обнаруживается, что небольшие, нерелевантные части изображений позволяют произвести классификацию с высокой степенью достоверности, модель демонстрирует ошибку переинтерпретации, и для исправления этой ситуации потребуется дополнительная работа.

Нерелевантные детали, достаточные для классификации с высокой степенью достоверности (📷: B. Carter et al.)

В своей работе команда обнаружила, что это проблема не только для моделей, обученных на небольших пользовательских наборах данных. Она также был обнаружена в моделях, обученных на больших, хорошо известных и часто используемых наборах данных, таких как CIFAR-10 и ImageNet. Это указывает на то, что чрезмерная интерпретация, вероятно, станет серьезной проблемой в мире классификации изображений. Это особенно тревожное открытие, если учесть, что классификаторы изображений используются в широком спектре приложений, включая медицинскую диагностику и автономную навигацию транспортных средств.

Хотя основное внимание в этом исследовании было уделено обнаружению чрезмерной интерпретации в модели, оно поднимает естественный вопрос - что мы можем с этим поделать? Безусловно, потребуются дальнейшие исследования, чтобы дать адекватный ответ, однако представленные выводы о том, что модели могут фокусироваться на фоне изображений или границах, предполагают, что нам могут потребоваться новые наборы данных, в которых объекты, которые мы хотим классифицировать, изображены с неинформативным фоном. По иронии судьбы, если мы хотим распознавать объекты в реальном мире, нам нужно использовать изображения, снятые в контролируемой среде, а не набор разнообразных изображений из реального мира.